기존의 틀에서 벗어난 검색: 구글이 검색을 보다 자연스럽고 직관적으로 만드는 방법

이 블로그는 구글 The Keyword 블로그(영문)에서도 확인하실 수 있습니다.

구글은 20년 넘게 전 세계의 정보를 체계화해 모두가 편리하게 접근하고 이용할 수 있도록 하는 사명에 헌신하고 있습니다. 제일 처음 텍스트 검색으로 시작했지만 시간이 지나면서 더욱 자연스럽고 직관적으로 정보를 찾는 방법을 계속 개발하고 있습니다. 그 결과 이제는 카메라를 이용해 눈으로 보는 것을 검색하거나 목소리로 소리 내어 질문할 수 있습니다.

오늘 개최된 서치 온(Search On) 행사에서 구글은 인공지능의 발전이 어떻게 정보 제품에 혁신을 불러올 수 있는지를 또 한번 입증했습니다. 구글은 검색창을 뛰어넘어 보다 인간의 생각처럼 작동하며 인간만큼 다차원적인 검색 경험을 만들어 내고 있습니다.

구글은 사람들이 본능적으로 하듯 자연스럽게 이미지, 소리, 텍스트 및 말을 조합해 찾고자 하는 것을 정확히 찾을 수 있는 세상을 꿈꿉니다. 이용자는 적은 수의 단어나 심지어 아예 한 단어도 사용하지 않으면서 질문할 수 있고 구글은 그것을 이용자의 의도대로 정확히 이해할 것입니다. 또한 이용자가 이해하기 쉬운 방식으로 정리된 정보를 탐색할 수 있을 것입니다.

구글은 이를 더욱 자연스럽고 직관적인 검색 구현이라고 말합니다. 이 비전을 모든 곳에 있는 사람들을 위해 실현하고자 장기적인 전략을 추진하고 있습니다. 구글이 정보 제품의 미래를 어떻게 발전시키고 있는지 대략적으로 알려 드리기 위해 오늘 서치 온 행사에서 공개했던 것 중 가장 주목할만한 3가지 기능을 소개합니다.

보다 자연스러운 시각적 검색

수백 년 전부터 사용되어왔던 카메라는 보통 추억을 간직하거나 최근에는 콘텐츠를 제작하는 수단으로 여겨지고 있습니다. 하지만 카메라는 정보에 접근하고 주변 세상을 이해하는 강력한 도구이기도 하며 이런 의미에서 제2의 키보드라고도 할 수 있습니다. 이런 이유로 구글은 2017년 구글 렌즈(Google Lens)를 도입해 사용자가 카메라나 이미지를 통해 보이는 것을 검색할 수 있게 했습니다. 이제 시각적 검색의 시대가 도래했습니다. 실제로 사람들은 월 80억 개의 질문에 답을 얻기 위해 구글 렌즈를 이용하고 있습니다.

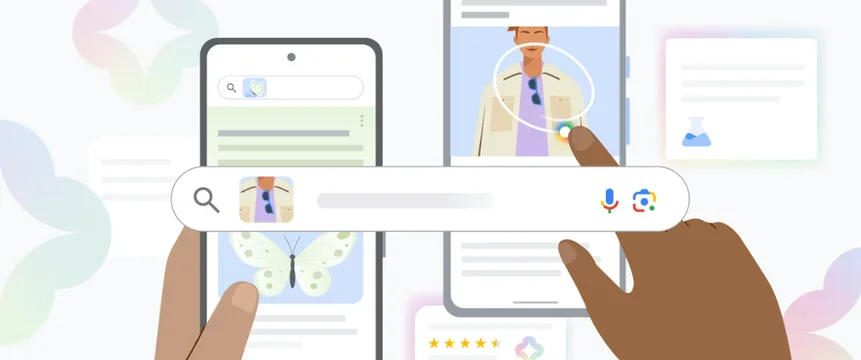

구글은 멀티서치(multisearch)를 통해 더욱 자연스러운 시각적 검색이 가능하도록 개선하고 있습니다. 멀티서치는 마치 친구에게 무언가를 가리키면서 질문을 하듯 이미지와 텍스트를 동시에 이용해 검색하는 완전히 새로운 검색 방식입니다. 구글은 올해 초 미국에서 멀티서치를 베타 버전으로 도입했고, 오늘 서치 온 행사에서는 향후 몇 개월 후 해당 기능을 70 개 이상의 언어로 확대하겠다고 발표했습니다. 나아가 멀티서치 기능을 ‘멀티서치 니어 미(multisearch near me)’로 한 단계 더 발전시키고자 합니다. 이를 통해 요리나 식물 등 익숙하지 않은 아이템에 대해 사진을 찍으면 해당 물건을 근처 식당이나 꽃집에서 찾을 수 있습니다. ‘멀티서치 니어 미’ 기능은 먼저 올가을 미국에서 영어 버전으로 출시합니다.

멀티서치는 이미지와 텍스트를 동시에 이용하는 완전히 새로운 검색 방식이다.

내 주변 세상 번역하기

시각적 이해의 가장 강력한 측면 중 하나는 언어 장벽을 허무는 능력입니다. AI 발전 덕분에 구글은 텍스트 번역을 넘어 이미지 번역에 이르렀습니다. 사람들은 이미 구글을 이용해 100개 이상의 언어로 월 10억회 이상의 이미지 내 텍스트를 번역합니다. 그로 인해 상점명, 메뉴, 간판 등을 즉시 읽을 수 있습니다.

하지만 대부분의 경우 정작 의미를 전달하는 것은 단어와 배경 이미지와 같은 문맥의 조합입니다. 구글은 이제 GAN(Generative Adversarial Network)이라고 하는 머신러닝 기술 덕분에 번역된 텍스트를 배경 이미지에 조화롭게 얹을 수 있습니다. 예를 들어 다른 언어로 된 잡지에 카메라를 갖다 대면 번역된 텍스트를 이미지 위에 덮어씌워 사실적으로 보여줍니다.

새로운 렌즈 번역 업데이트를 통해 번역된 텍스트를 이미지 위에 덮어씌워 사실적으로 보여준다.

몰입형 뷰로 세상 탐험

더욱 자연스럽고 직관적인 경험을 제공하고자 하는 구글의 노력은 이용자가 현실 세계를 탐색하는 데 도움을 주려는 목적도 있습니다. 컴퓨터 비전과 예측 모델의 발전 덕분에 구글은 지도의 역할을 완전히 재정의하고 있습니다. 다시 말해 2D 지도가 현실 세계의 다차원 뷰로 진화해 마치 그 장소에 있는 것과 같은 경험을 할 수 있습니다.

네비게이션의 실시간 교통정보가 구글 지도를 훨씬 더 유용하게 만든 것처럼 구글 지도의 몰입형 뷰를 통해 날씨, 장소 혼잡도 등 유용한 인사이트를 생생하게 제공함으로써 지도 분야에서 또 다른 중요한 발전을 이뤘습니다. 다시 말해 이용자는 이 새로운 경험을 통해 해당 장소에 발을 들여놓기도 전에 장소에 대한 현장감을 느끼게 됨으로 언제 어디로 가야 할지 자신 있게 결정할 수 있게 될 것입니다.

예를 들어 식당에서 친구와 만날 경우 그 동네와 식당을 줌으로 확대해 약속한 요일과 시간대에 해당 장소의 분위기를 파악하고, 날씨를 시각화하거나 혼잡도를 미리 확인할 수 있습니다. 구글의 진보된 전 세계의 이미지들을 예측 모델과 융합해 내일, 다음 주 혹은 다음 달에 해당 장소가 어떤 모습일지 느낄 수 있도록 돕습니다. 오늘 첫 단계로 250개 랜드마크의 항공 뷰를 제공하고, 몰입형 뷰는 앞으로 몇 개월 안에 5개 대도시를 시작으로 추가될 예정입니다.

구글 지도의 몰입형 뷰는 방문하기도 전에 해당 장소에 대한 분위기를 느낄 수 있게 해준다.

지금까지 소개한 기능들은 서치 온에서 소개된 다른 많은 기능과 함께 구글이 기존의 검색창을 뛰어넘어 보다 많은 도움을 제공하기 위해 제품을 혁신하고 있는 시작점에 불과합니다. 구글은 이용자가 각자에게 가장 자연스러운 방식으로 정보를 이해하고 그들의 삶과 특성에 적합한 기술을 개발하기 위해 꾸준히 노력하고 있습니다.