유용했던 구글 이미지부터 놀라운 AI까지, 구글 검색에서 가장 중요하고 의미 있었던 25번의 모먼트

이 블로그는 구글 The Keyword 블로그(영문)에서도 확인하실 수 있습니다.

구글이 25년 전에 처음 출시되었을 때는 최초의 검색 엔진과는 거리가 멀었습니다. 하지만 구글 검색(Google Search)은 사람들이 원하는 정확한 정보를 생각보다 빠르게 찾을 수 있도록 도와주는 유용함으로 이내 유명해졌습니다.

구글은 오랜기간 혁신을 거듭하며 매일 구글 검색 성능을 더욱 더 개선하기 위해 노력해 왔습니다. 완전히 새로운 검색 방법을 개발하는 것부터 수백만 개의 비즈니스가 검색 결과 목록과 광고를 통해 고객과 연결되도록 지원하는 것(최초는 2001년 애드워즈로 시작된 지역 비즈니스 광고), 기념일 로고(Doodles), 구글 제품과 서비스에 추가된 재미있는 트릭인 이스터 에그(Easter Eggs)까지 매우 긴 여정을 걸어왔습니다.

창립 25주년을 맞이하여 구글은 중요한 순간마다 구글 검색의 유용성을 더욱 높이고 구글의 현재를 만드는데 크게 기여한 이정표를 되돌아보고자 합니다. 더 자세한 구글 검색의 역사는 시간과 함께 진화한 검색(Search Through Time) 사이트에서도 알아볼 수 있습니다.

2001년: 구글 이미지(Google Images)

2000년 제니퍼 로페즈(Jennifer Lopez)가 그래미 시상식에 참석하며 입었던 파격적인 베르사체 드레스는 패션계의 전설이 되었으며, 그 당시 구글의 가장 인기있는 검색어였습니다. 그러나 당시 검색결과에는 파란색 링크 목록만 표시되었기 때문에 이용자들이 원하는 실제 드레스 사진을 쉽게 찾을 수 없었습니다. 구글은 이를 계기로 구글 이미지를 만들게 되었습니다.

2001년: "이것을 찾으셨나요?"(“Did you mean?”)

검색어 입력의 맞춤법 교정을 제안하는 "이것을 찾으셨나요?"는 머신러닝을 처음으로 적용한 기능 중 하나였습니다. 이전에는 철자가 틀린 단어로 검색을 하면 해당 주제에 가장 적합한 페이지가 아닌 철자가 틀린 단어로 검색된 페이지가 표시되었습니다. 구글은 수 년에 걸쳐 실수로 검색어를 잘못 입력하더라도 원하는 내용을 찾을 수 있도록 지원하는 새로운 인공지능(AI) 기반의 기술을 개발했습니다.

2002년: 구글 뉴스(Google News)

2001년 9월 11일, 비극적인 사건이 발생했을 때 사람들은 검색을 통해 최신 정보를 찾는 데 어려움을 겪었습니다. 구글은 실시간 뉴스를 원하는 이용자들을 위해 특정 뉴스에 대한 다양한 출처가 연결되는 링크를 제공하는 구글 뉴스를 2002년 출시했습니다.

2003년: 이스터 에그(Easter eggs)

구글 직원들은 수 년 동안 특정 단어를 검색하면 흥미로운 화면을 표시하는 이스터 에그 기능을 개발했습니다. 2003년에 선보인 첫 번째 이스터 에그 중 하나는 영국 작가 더글라스 아담스(Douglas Adams)의 소설 ‘은하수를 여행하는 히치하이커를 위한 안내서’에 나오는 문구 ‘삶과 우주, 그리고 모든 것에 대한 답(answer to life, the universe and everything)’을 검색 시 소설에서처럼 42라는 숫자가 표시되는 이스터 에그였습니다. 그 후로 수백만 명의 사람들이 비스듬하게 표시되는 페이지 화면(검색어: askew), 빙빙도는 페이지 화면(검색어: do a barrel roll), 검색어가 계속 반복되는 화면(검색어: recursion) 등은 물론, 대중 문화의 기념적인 순간들을 이스터 에그를 통해 즐기기도 하였습니다.

2004년: 자동 완성(Autocomplete)

우리가 생각하는 속도만큼 빠르게 검색어를 입력할 수 있다면 얼마나 좋을까요? 구글의 자동 완성 기능은 이용자에게 검색창의 검색어를 자동으로 예측해 알려주는 'Google Suggest '라는 이름으로 처음 출시된 기능입니다. 현재 자동 완성 기능은 평균적으로 입력 시간을 25% 줄여주며, 매일 약 200년 이상의 검색어 입력 시간을 절약해줍니다.

2004년: 지역 정보(Local information)

과거에는 사람들이 업체 정보를 얻기 위해 전화번호부에 의존했습니다. 웹은 ‘서울에 있는 피자집’ 또는 ‘역삼동 미용실’과 같이 특정 지역 정보를 쉽게 검색할 수 있는 길을 열었습니다. 2004년에 Google Local은 지도, 길찾기, 리뷰와 같은 지역 관련 정보를 제공하기 시작했습니다. 2011년에는 모바일에서 click to call 기능을 추가하여 이동 중에도 업체와 쉽게 연락할 수 있도록 했습니다. 구글검색에서 지역 검색결과는 전화, 길 찾기, 음식 주문, 예약 등 매달 평균적으로 65억 건 이상의 비즈니스 연결을 이끌어내고 있습니다.

2006년: 구글 번역(Google Translate)

2002년부터 구글의 연구원들은 온라인 환경에서의 언어 장벽을 해소하고자 기계 번역 기술을 개발하기 시작했습니다. 4년 후, 구글은 아랍어와 영어 간 텍스트 번역을 제공하는 구글 번역을 출시했습니다. 현재 구글 번역은 2022년에 추가된 24개 언어를 포함하여 100개 이상의 언어를 지원하고 있습니다.

2006년: 구글 트렌드(Google Trends)

구글 트렌드는 집계된 데이터를 통해 검색 트렌드를 이해하고 매년 올해의 검색어를 선정하기 위해 개발되었습니다. 오늘날 구글 트렌드는 언론인, 연구원, 학자 및 기업에 시간의 흐름에 따라 검색어가 어떻게 변화하는지 파악할 수 있도록 지원하는 세계 최대의 무상 데이터 세트가 되었습니다.

2007년: 범용 검색(Universal Search)

검색결과가 유용하기 위해서는 링크, 이미지, 동영상, 지역 검색결과 등 다양한 형식의 관련 정보가 모두 포함되어야 합니다. 때문에 구글은 모든 유형의 콘텐츠를 한 번에 검색하고, 여러 유형의 검색결과를 표시할 시점과 상황을 판단해, 더 명확하고 직관적인 방식으로 결과를 제공하도록 시스템을 다시 설계했습니다. 그 결과 2007년에 출시된 범용 검색은 구글 검색에서 가장 혁신적인 변화였습니다.

2008년: 구글 모바일 앱(Google Mobile App)

애플의 앱스토어가 출시되면서 구글에서도 아이폰을 위한 구글 모바일 앱을 처음으로 출시했습니다. ‘자동 완성’, '’내 위치' 등의 기능은 키를 더 적게 누르면서 편리하게 검색할 수 있도록 해주어작은 화면에서 특히 유용했습니다. 오늘날에는 렌즈(Lens)로 수학 숙제에 대한 도움을 받는 것부터 탭 한 번으로 시각적 번역 도구에 액세스하는 것까지 안드로이드(Android)와 iOS 환경 모두에서 사용할 수 있는 구글 앱으로 할 수 있는 일이 매우 다양합니다.

2008년: 음성 검색(Voice Search)

2008년에 구글 모바일 앱에 음성 검색 기능을 도입한 후 2011년에는 음성 검색 기능을 데스크톱으로 확장했습니다. 음성 검색 기능을 통해 이용자들은 버튼 하나만 누르면 음성으로 편리하게 검색을 할 수 있게 되었습니다. 오늘날 음성 검색은 특히 인도에서 인기가 높으며, 매일 음성으로 검색을 하는 인도인의 비율은 전 세계 평균의 두 배에 이릅니다.

2009년: 긴급 핫라인

딸이 위험할 수 있는 음식을 삼킨 후 독극물 관리 정보를 찾는 데 어려움을 겪은 한 어머니의 제안에 따라 구글은 검색 결과 페이지 상단에 독극물 관리 핫라인을 위한 상자를 만들었습니다. 이 서비스 출시 이후, 자살 예방과 같은 위급한 순간을 위한 긴급 핫라인도 강화했습니다.

2011년: 이미지를 사용해 검색하기(Search by Image)

검색하려는 내용을 단어로 설명하기 어려울 때가 있습니다. 이를 위해 구글은 이미지를 사용하는 검색하기 기능을 출시했습니다. 이용자는 이 기능으로 사진이나 이미지 URL을 업로드한 후 해당 이미지가 무엇인지, 웹에서 해당 이미지가 어디에 있는지 찾을 수 있습니다. 이미지 사용해 검색하기 기능은 이후 구글 렌즈를 위한 기반이 되었습니다.

2012년: 지식 그래프(Knowledge Graph)

구글은 전 세계의 인물, 장소, 사물에 대한 방대한 정보와 이들이 서로 어떻게 연관되어 있는지를 보여주는 지식 그래프를 도입하여 이용자들이 더 쉽고 빠르게 답변을 얻을 수 있도록 했습니다. 지식 그래프를 기반으로 구현된 첫 번째 기능인 지식 패널(Knowledge Panels)에서는 유명인, 도시, 스포츠 팀 등의 주제에 대한 정보를 한눈에 확인할 수 있습니다.

2015년: 인기 시간대(Popular Times)

검색 및 지도 서비스에 인기 시간대 기능을 출시하여 사람들이 식당, 상점, 박물관과 같은 장소를 검색할 때 하루 중 가장 붐비는 시간을 확인할 수 있도록 했습니다.

2016년: 디스커버(Discover)

개인화된 피드(현재의 디스커버)를 출시하여 사람들이 검색을 하지 않고도 구글 앱에 접속하면 바로 자신의 관심사에 맞는 콘텐츠를 살펴볼 수 있도록 지원했습니다.

2017년: 렌즈(Lens)

구글 렌즈는 사진 속의 사물을 식별하여 이를 다른 이미지와 비교한 후, 원본 사진과의 유사성 및 관련성을 기준으로 다른 이미지의 순위를 지정하여 카메라 속 대상을 검색어로 전환합니다. 이제 눈 앞의 대상을 구글 앱을 통해 검색할 수 있는 것 입니다. 현재 렌즈는 매달 120억 건 이상의 시각적 검색을 처리하고 있습니다.

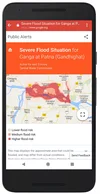

2018년: 홍수 예측

구글은 AI를 사용해 사람들이 곧 일어날 홍수에 잘 대비할 수 있도록 대규모 홍수가 발생할 지점 및 장소를 효과적으로 예측하는 모델을 개발했습니다. 이 모델은 인도에서 처음 시작해 지금은 홍수 예측 알림을 80개국으로 확대하였습니다.

2019년: BERT

검색의 유용성을 가장 높여 주는 것은 언어를 이해하는 능력입니다. 2018년에 구글은 BERT(Bidirectional Encoder Representations from Transformers)라는 언어 이해 모델을 훈련시키기 위해 신경망 기반의 기술을 도입하고 이를 오픈소스로 공개했습니다. BERT는 단어의 전체 문맥을 파악하여 언어를 더 효과적으로 이해하도록 함으로써 검색의 유용성을 높입니다. 2019년, 구글은 엄격한 테스트를 거쳐 70개 이상의 언어에 BERT를 적용했습니다.

2020년: 쇼핑 그래프(Shopping Graph)

모든 업체와 브랜드가 구글에 제품을 무료로 노출할 수 있게 되면서 온라인 쇼핑이 훨씬 더 간편해지고 그 범위도 세상의 모든 물건을 다룰 만큼 확대되었습니다. 또한 AI 기반 데이터 세트인 쇼핑 그래프를 도입하여, 350억 개에 달하는 제품, 판매자, 브랜드, 리뷰, 지역 재고에 관한 데이터가 지속적으로 업데이트되고 있습니다.

2020년: Hum to Search

구글의 Hum to Search 앱을 사용하면 머릿속에서 맴도는 노래가 정확히 기억나지 않아도 노래를 찾을 수 있습니다. 흥얼거리거나 휘파람을 불거나 멜로디를 부르면 머신러닝 기능이 일치할 만한 노래를 찾아줍니다. 그 다음에 노래와 아티스트에 대한 정보를 찾아볼 수 있습니다.

2021년: 검색결과 정보(About this result)

구글은 사람들이 어떤 결과가 자신에게 가장 유용하고 믿을 수 있는지를 판단할 수 있도록 돕기 위해 대부분의 검색결과 옆에 '검색결과 정보' 패널을 추가했습니다. 이 기능은 정보 리터러시 전문가의 권장사항을 기반으로 해당 결과가 표시되는 이유를 설명하고 콘텐츠 및 출처에 대한 추가 컨텍스트를 제공합니다. 이제 검색결과 정보 기능은 검색 기능을 사용할 수 있는 모든 언어에서 제공됩니다.

2022년: 멀티서치(Multisearch)

구글은 매우 까다로운 정보라도 원하는 정보를 쉽게 찾을 수 있도록 멀티서치를 통해 텍스트와 이미지를 동시에 검색할 수 있는 완전히 새로운 방법을 개발했습니다. 이제 식탁과 의자 사진을 찍고 '커피 테이블'이라는 검색어를 더해 일치하는 테이블을 찾을 수도 있습니다. 미국에서 처음 출시된 멀티서치는 이제 전 세계 모든 언어와 렌즈를 사용할 수 있는 국가에서 구글 모바일앱을 통해 사용할 수 있습니다.

2023년: 구글 검색 실험실(Search Labs) 및 Search Generative Experience (SGE)

구글은 매년 구글 검색이 사람들에게 도움이 되는 방법을 찾기 위해 수십만 번의 실험을 진행하고 있습니다. 구글 검색 실험실(Search Labs)을 통해 초기 단계의 실험을 테스트해 보고 담당 팀에게 직접 피드백을 전할 수도 있습니다. 첫 번째 실험인 SGE는 생성형 AI를 검색에 직접 도입한 것으로 AI 기반의 개요가 표시되고 이를 바탕으로 추가적인 정보를 탐색하며 자연스러운 방식으로 후속 검색을 요청하는 과정에서 특정 주제의 요점을 파악할 수 있습니다. 구글은 미국에서 처음 SGE를 출시한 이후 새로운 기능을 빠르게 추가했으며, 앞으로도 더 많은 기능을 추가할 예정입니다.

20년이 넘는 기간 동안 구글 검색 엔진의 발전을 지켜본 사람으로서, 구글이 어디서부터 시작했고 얼마나 많은 성과를 이루었는지 돌이켜 보면 정말 놀라울 뿐입니다.